Informationstechnik

Fake-Bilder anhand von Frequenzanalysen erkennen

Diese Methode entlarvt unechte Bilder, die von Computeralgorithmen und nicht von Menschen erzeugt wurden.

Sie wirken täuschend echt, sind aber von Computern gemacht: Sogenannte Deep-Fake-Bilder werden mithilfe von maschinellem Lernen generiert und sind für menschliche Betrachter kaum von realen Fotos zu unterscheiden. Forscherinnen und Forscher des Horst-Görtz-Instituts für IT-Sicherheit der RUB und des Exzellenzclusters „Cyber Security in the Age of Large-Scale Adversaries“ (Casa) haben eine neue Methode entwickelt, mit der sich Deep-Fake-Bilder effizient identifizieren lassen. Dazu analysieren sie die Motive im Frequenzbereich. So werden typische Artefakte sichtbar, die Computermodelle in ihre Bilder einbauen.

Über das Verfahren berichtete das Team am 15. Juli 2020 auf der International Conference on Machine Learning (ICML), einer der führenden Konferenzen im Bereich des maschinellen Lernens.

Gerade in Zeiten von Fake News kann das ein Problem sein.

Thorsten Holz

Deep-Fake-Bilder werden mithilfe von Computermodellen erzeugt, sogenannten Generative Adversarial Networks, kurz GANs. Die Technik hat in den vergangenen Jahren dazu beigetragen, dass computergenerierte Bilder immer authentischer geworden sind. Auf der Website www.whichfaceisreal.com können User selbst testen, ob sie Fake-Motive von Originalfotos unterscheiden können.

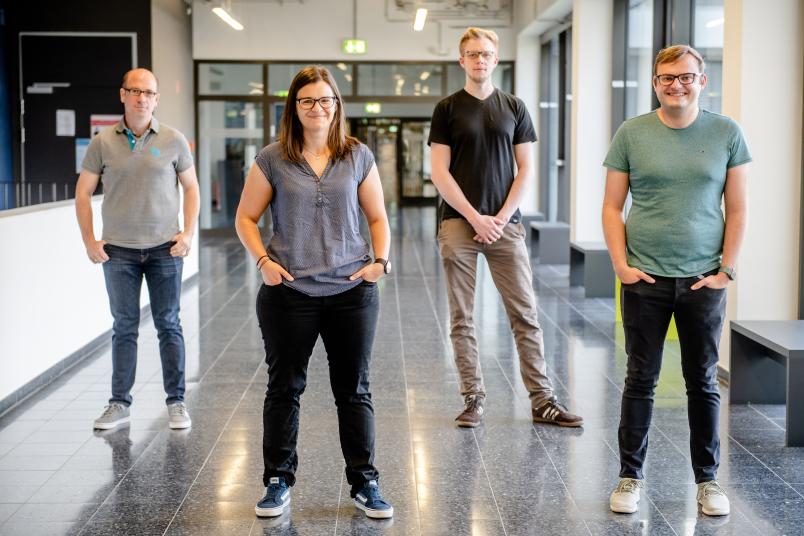

„Gerade in Zeiten von Fake News kann es ein Problem sein, wenn Nutzerinnen und Nutzer computergenierte Motive und Originale nicht auseinanderhalten können“, sagt Prof. Dr. Thorsten Holz vom Lehrstuhl für Systemsicherheit, von dem auch Joel Frank und Thorsten Eisenhofer an der Studie beteiligt waren. Die Gruppe kooperierte mit Prof. Dr. Asja Fischer vom Lehrstuhl für Maschinelles Lernen sowie Lea Schönherr und Prof. Dr. Dorothea Kolossa von der Arbeitsgruppe für Kognitive Signalverarbeitung.

Frequenzanalyse offenbart typische Artefakte

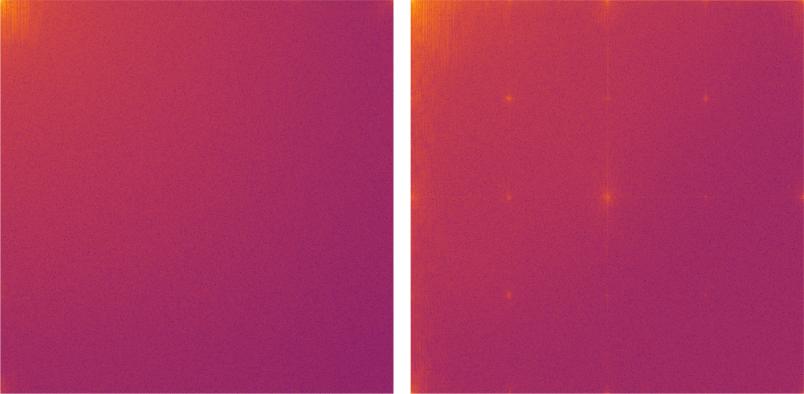

Bisher wurden Deep-Fake-Bilder mit aufwendigen statistischen Verfahren untersucht. Die von der Bochumer Gruppe durchgeführte Frequenzanalyse zeigte, dass von GANs generierte Bilder verschiedene Arten von Artefakten im hochfrequenten Bereich aufweisen. So wird in der Frequenzdarstellung von gefälschten Bildern beispielsweise eine typische Gitterstruktur sichtbar.

„Unsere Experimente haben ergeben, dass diese Artefakte nicht nur bei GANs auftreten, sondern dass es sich um ein strukturelles Problem aller Deep-Learning-Algorithmen handelt“, erklärt Joel Frank. „Wir gehen davon aus, dass man anhand der in unserer Studie beschriebenen Artefakte immer erkennt, ob es sich um ein Deep-Fake-Bild handelt, das mit maschinellem Lernen erstellt wurde.“