Elektrotechnik 3D-Mapping von Räumen mittels Radar

Diese Technik könnte eines Tages bei der Suche nach Opfern von Naturkatastrophen oder Brandunglücken helfen.

Ingenieure der Universitätsallianz Ruhr haben neue Signalverarbeitungsverfahren für die Bildgebung und Materialcharakterisierung mittels Radar entwickelt. Langfristiges Ziel ist es, diese Techniken mit der radarbasierten Ortung von Gegenständen zu kombinieren. Die Vision: eine fliegende Plattform, die selbstständig eine dreidimensionale Repräsentation des umgebenden Raums erzeugen kann. Nützlich könnte die Technik zum Beispiel sein, um bei einem Brand herauszufinden, was die Feuerwehrleute hinter den Rauchwolken im Gebäude erwartet.

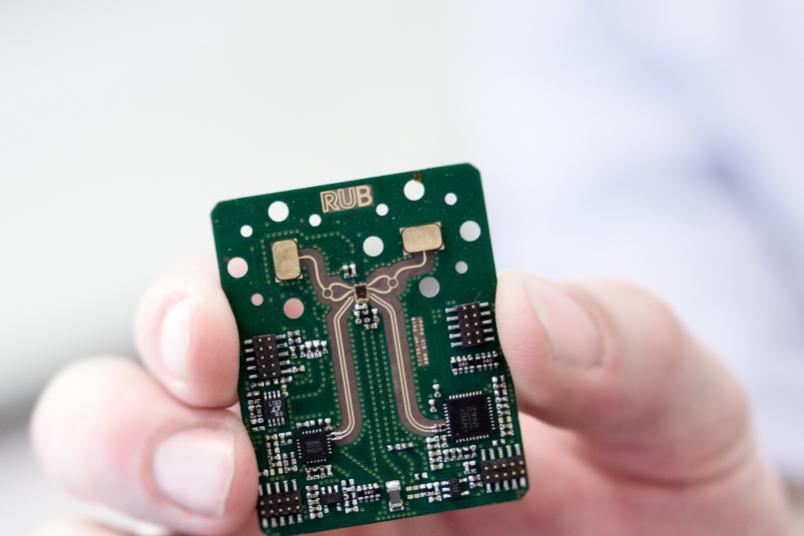

Zu diesem Zweck kooperieren Wissenschaftlerinnen und Wissenschaftler der Ruhr-Universität Bochum (RUB) und der Universität Duisburg-Essen (UDE) mit weiteren Einrichtungen im Sonderforschungsbereich/Transregio 196 „Marie“, kurz für „Mobile Materialcharakterisierung und -ortung durch elektromagnetische Abtastung“. Das Bochumer Wissenschaftsmagazin Rubin berichtet über die Arbeiten.

Ein Messverfahren, viele Informationen

Prinzipiell taugt das gleiche Messverfahren für die Materialcharakterisierung und die Ortung. Nur wird es derzeit noch nicht gleichzeitig für beides eingesetzt. Das Prinzip: Ein Radar strahlt elektromagnetische Wellen ab, die an Objekten reflektiert werden. Grob gesagt lässt sich aus der Laufzeit der eingestrahlten und zurückgeworfenen Signale berechnen, wie weit ein Gegenstand entfernt ist.

In den zurückkommenden Wellen steckt aber noch mehr Information. Die Stärke des reflektierten Signals hängt nämlich davon ab, wie groß ein Objekt ist, wie es geformt ist und aus welchem Material es besteht. Eine Materialkonstante, die sogenannte relative Permittivität, beschreibt, wie durchlässig eine Substanz für elektromagnetische Wellen ist. Aus der Permittivität können die Forscher also Rückschlüsse ziehen, um welches Material es sich handeln könnte.

Echtzeitanalyse möglich

Ein Radarsignal in ein aussagekräftiges Bild umzuwandeln erfordert hohen Rechenaufwand. Die aufgezeichneten Daten sind etwa so wie von einer Kamera, der die Linse zum Fokussieren fehlt. Die Fokussierung erfolgt nachträglich im Computer. Algorithmen für diesen Prozess entwickelte Jan Barowski während seiner Promotion am Bochumer Lehrstuhl für Hochfrequenzsysteme, den Prof. Dr. Ilona Rolfes leitet. „Als ich angefangen habe, hat eine solche Korrektur noch zehn Stunden gedauert“, sagt der Ingenieur. Heute läuft die Auswertung über eine Laptop-Grafikkarte in Echtzeit. Barowskis Algorithmen erledigen dabei nicht nur die Fokussierung, sondern eliminieren auch systembedingte Messfehler aus den Daten.

Das aktuell vorliegende System kann in einer kontrollierten Laborumgebung bereits erkennen, wo ein Objekt ist und dass es aus einem anderen Material bestehen muss als zum Beispiel der Untergrund, auf dem es liegt. Im nächsten Schritt wollen die Ingenieure das System befähigen zu erkennen, was das Objekt ist. Die Permittivität von Kunststoffen können sie bereits gut bestimmen, aber zum Beispiel noch nicht zwischen verschiedenen Kunststoffen unterscheiden. Schritt für Schritt wollen die Projektpartner das System nun für den Einsatz unter realistischen Bedingungen optimieren.