Linguistik

Die zerstörerische Kraft der Sprache

Künstliche Intelligenz kann Schimpfwörter gut identifizieren. Aber kann sie auch verstecktere Formen sprachlicher Gewalt erkennen?

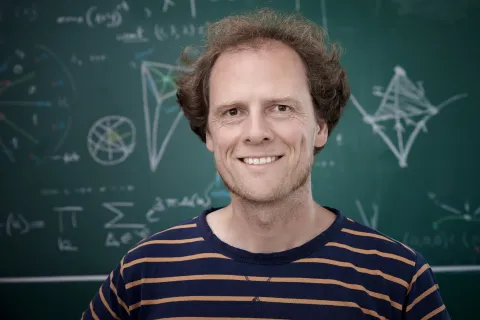

„Verpiss dich, du Schlampe!“ „Dich Penner werde ich bekommen. Ich stech’ dich ab.“ „Die sollte man alle abknallen.“ Nur ein paar Beispiele für die Form, die Sprache in den Sozialen Medien annehmen kann. Menschen werden beleidigt, bedroht oder zu Straftaten angestachelt. Was Hassrede und andere Formen von schädigender Sprache aus linguistischer Perspektive auszeichnet und wie man sie automatisch erkennen kann, interessiert Prof. Dr. Tatjana Scheffler. Sie forscht an der RUB im Bereich Digitale Forensische Linguistik.

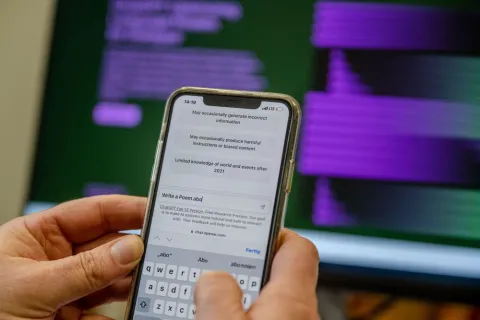

„Die Sprachverarbeitung allgemein hat in den vergangenen Jahren große Sprünge gemacht“, sagt Scheffler. Wer heute Übersetzungsprogramme wie den Google Translator oder Sprachassistenten wie Siri nutzt, erzielt deutlich bessere Ergebnisse als vor ein paar Jahren. Auch das Klassifizieren von Texten klappt mittlerweile ganz gut. Künstliche-Intelligenz-Algorithmen können lernen, Aussagen verschiedenen Kategorien zuzuordnen. So können sie etwa entscheiden, ob eine Textpassage eine direkte Beleidigung enthält oder nicht. Die Algorithmen lernen die Kategorien anhand von großen Trainingsdatensätzen, die Menschen zuvor klassifiziert haben. Später können sie das Wissen über die erlernten Kategorien dann auf neue Daten übertragen.

„Direkte Beleidigungen und Schimpfwörter sind so schon gut zu identifizieren“, weiß Tatjana Scheffler. Oft reicht ein Abgleich mit einer Wortliste, die häufig verwendete Beleidigungen enthält. Unter schädigender Sprache versteht die Forscherin aber viel mehr als offensichtliche Hassrede, die sich gegen einzelne Personen richtet. „Es gibt implizitere Formen, die gar nicht an einen bestimmten Adressaten oder eine Adressatin gerichtet sind“, sagt sie. „Man kann auch Schaden anrichten, indem man auf eine gewisse Weise über andere spricht oder eine bestimmte Stimmung herstellt.“

Schlimmstenfalls können solche Stimmungen in echte Handlungen umschlagen. Ein populäres Beispiel ist der Sturm auf das Kapitol durch Anhänger des damaligen US-Präsidenten Donald Trump am 6. Januar 2021. Die sozialen Medien werden mit dafür verantwortlich gemacht, dass die Lage so eskalieren konnte.

Telegram-Chat von Trump-Anhängern analysiert

Genau mit diesem Beispiel, dem Sturm auf das Kapitol, hat Tatjana Scheffler sich zusammen mit zwei Kolleginnen aus Berlin befasst. Die Gruppe arbeitete mit 26.431 Nachrichten von 521 Nutzerinnen und Nutzern des Messenger-Dienstes Telegram. Die Nachrichten wurden zwischen dem 11. Dezember 2016 und dem 18. Januar 2021 in einem öffentlichen Kanal gepostet, in dem sich Menschen mit extrem rechter Gesinnung austauschen. Inhaltlich startete ihre Diskussion mit der theoretischen Idee, die Regierung zu stürzen, und entwickelte sich schrittweise zu den konkreten Plänen, das Kapitol zu stürmen.

Das Team um Tatjana Scheffler überprüfte, wie gut bereits existierende Algorithmen in diesem Datensatz schädigende Sprache identifizieren konnten. Um die Trefferquote der Algorithmen bewerten zu können, analysierten sie etwa ein Fünftel der Nachrichten von Hand und verglichen ihre Ergebnisse mit denen der automatisierten Verfahren. Sie unterschieden dabei fünf verschiedene Formen von schädigender Sprache.

Fünf Kategorien schädigender Sprache

Die erste Kategorie beinhaltete aufwiegelnde Sprache, etwa Passagen wie „violence is 100000% justified now“ (Gewalt ist jetzt zu 100000% gerechtfertigt). Die zweite Kategorie umfasste abwertende Begriffe wie „scum“ (Abschaum) oder „retarded“ (zurückgeblieben). In der dritten Kategorie fasste das Team Ausdrücke zusammen, die an sich nicht abwertend sind, aber in dem Kontext, in dem sie auftraten, abfällig gemeint waren – etwa „they are a sickness“ (sie sind Krankheiten). Eine vierte Kategorie war dem sogenannten Othering gewidmet: Bemerkungen, die genutzt werden, um eine Gruppe Menschen von einer anderen abzugrenzen, wie in dem Beispiel: „Are women banned from this chat? If not, why the fuck not?“ (Sind Frauen aus diesem Chat ausgeschlossen? Falls nicht, warum verdammt noch mal nicht?). Die letzte Kategorie umfasste Insiderformulierungen, die eine Gruppe von Gleichgesinnten verwendet, um sich von anderen abzugrenzen und das Gruppengefühl zu stärken. Trump-Anhänger nutzen den Begriff „Patriot“ etwa auf eine bestimmte Art.

Automatisierte Verfahren und Menschen im Vergleich

Die auf diese Weise kodierten Kommentare ließen die Forscherinnen auch von automatisierten Verfahren labeln, wie Tech-Firmen sie nutzen, um Hassrede oder beleidigende Sprache ausfindig zu machen. 4.505 Nachrichten gingen in den Vergleich ein. 3.395 davon stuften sowohl die Wissenschaftlerinnen als auch die automatisierten Verfahren als nicht schädigend ein, bei 275 waren sie sich einig, dass sie schädigende Sprache enthielten. 835 Nachrichten hingegen bewerteten Mensch und Maschine unterschiedlich: Etwa die Hälfte stuften die Algorithmen fälschlicherweise als Hassrede oder Beleidigung ein; den Rest erkannten sie – anders als die Wissenschaftlerinnen – nicht als schädigende Sprache.

Bestimmte grammatische Strukturen können ein Hinweis darauf sein, dass ein Begriff abwertend gemeint ist.

Tatjana Scheffler

Gerade bei aufwiegelnden Kommentaren, Insiderbegriffen und Othering lagen die automatisierten Verfahren oft daneben. „Wenn wir sehen, in welchen Fällen etablierte Methoden Fehler machen, hilft uns das, künftige Algorithmen besser zu machen“, resümiert Tatjana Scheffler. Mit ihrem Team entwickelt sie auch selbst automatisierte Verfahren, die schädigende Sprache noch besser erkennen sollen. Dazu braucht es zum einen bessere Trainingsdaten für die Künstliche Intelligenz. Zum anderen müssen aber auch die Algorithmen selbst optimiert werden. Hier kommt wieder die Linguistik ins Spiel: „Bestimmte grammatische Strukturen können zum Beispiel ein Hinweis darauf sein, dass ein Begriff abwertend gemeint ist“, erklärt Scheffler. „Wenn ich sage ‚Du Lauch‘ ist das etwas anderes als wenn ich nur ‚Lauch‘ sage.“

Algorithmen verbessern

Nach solchen sprachlichen Merkmalen sucht Tatjana Scheffler, um die Algorithmen der nächsten Generation mit weiterem Hintergrundwissen zu füttern. Auch Kontextinformationen könnten den Maschinen helfen, schädigende Sprache zu finden. Welche Person hat den Kommentar abgegeben? Hat sie sich früher schon abfällig über andere geäußert? Wer wird adressiert – eine Politikerin oder ein Journalist? Diese Gruppen sind besonders häufig verbalen Angriffen ausgesetzt. Auch solche Informationen könnten die Trefferquote einer Künstlichen Intelligenz erhöhen.

Ohne die Expertise des Menschen wird es nicht gehen.

Tatjana Scheffler

Ohne maschinelle Unterstützung wird sich das Problem der schädigenden Sprache nicht in den Griff bekommen lassen, davon ist Tatjana Scheffler überzeugt. Zu groß ist das Volumen an Kommentaren, als dass Menschen sie ohne Unterstützung alle sichten und bewerten könnten. „Ohne die Expertise des Menschen wird es aber auch nicht gehen“, stellt die Forscherin klar. Denn es wird immer Fälle geben, in denen die Maschinen irren oder sich nicht sicher sind.

Originalveröffentlichung