IT-Sicherheit

Gefälschte Sprachdateien erkennen

Künstliche Intelligenz kann die Stimmen von Personen imitieren. Betrüger nutzen das am Telefon bereits aus. Ein Bochumer Team arbeitet an Gegenmaßnahmen.

Maschinen können mithilfe von Künstlichen-Intelligenz-Algorithmen Fotos oder Sprachdateien erzeugen, die wie aus dem wahren Leben aussehen oder klingen. Wie man solche als Deepfakes bezeichneten künstlich erzeugten Daten von echten unterscheiden kann, interessiert Forschende am Horst-Görtz-Institut für IT-Sicherheit der Ruhr-Universität Bochum. Sie stellten fest, dass sich echte und gefälschte Sprachdateien im Bereich der hohen Frequenzen unterscheiden. Zuvor waren Deepfakes hauptsächlich bei Bildern untersucht worden. Die neuen Erkenntnisse sollen künftig helfen, auch gefälschte Sprache erkennen zu können.

Ihre Ergebnisse stellten Joel Frank vom Lehrstuhl für Systemsicherheit und Lea Schönherr aus der Arbeitsgruppe Kognitive Signalverarbeitung am 7. Dezember 2021 auf der Conference on Neural Information Processing Systems vor, die als Online-Veranstaltung abgehalten wurde. Die Arbeiten fanden im Rahmen des Exzellenzclusters CASA – Cybersecurity in the Age of Large-Scale Adversaries statt.

Großer Deepfake-Datensatz erzeugt

Als ersten Schritt erzeugten Joel Frank und Lea Schönherr einen umfangreichen Datensatz mit rund 118.000 künstlich erzeugten Sprachdateien. So entstanden etwa 196 Stunden Material auf Englisch und Japanisch. „Solch einen Datensatz für Audio-Deepfakes hat es zuvor nicht gegeben“, erklärt Lea Schönherr. „Um die Methoden zur Erkennung von gefälschten Audiodateien zu verbessern, braucht man aber dieses Material.“ Damit der Datensatz möglichst breit aufgestellt ist, nutzte das Team sechs verschiedene Künstliche-Intelligenz-Algorithmen beim Erzeugen der Audioschnipsel.

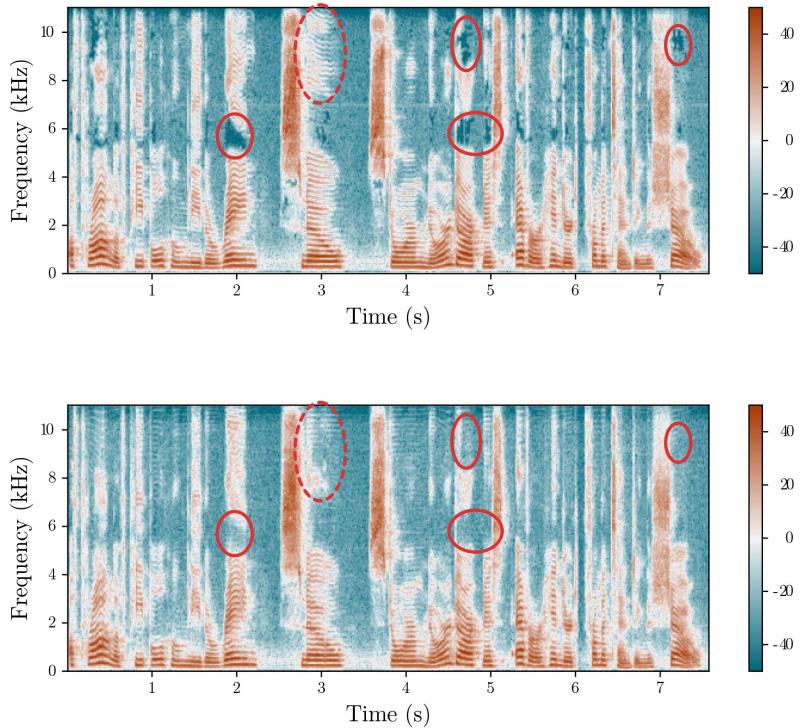

Anschließend verglichen die Forschenden die künstlichen Audiodateien mit Aufnahmen echter Sprache. Sie stellten die Dateien in Form von Spektrogrammen dar, die die Frequenzverteilung über die Zeit hinweg zeigen. Der Vergleich ergab feine Unterschiede im Bereich der hohen Frequenzen zwischen echten und gefälschten Dateien.

Basierend auf diesen Erkenntnissen entwickelten Frank und Schönherr Algorithmen, die zwischen Deepfakes und echter Sprache unterscheiden können. Diese Algorithmen sind als Startpunkt für andere Forscher gedacht, um neue Erkennungsmethoden zu entwickeln.