Die Forschenden deckten verschiedene Propaganda-Netzwerke auf Telegram auf.

Informatik

Erster Detektionsmechanismus für Propaganda auf Telegram entwickelt

Die neue Methode funktioniert effizient, schnell und günstig. Das könnte Moderatorinnen und Moderatoren im Kampf gegen Desinformationen auf Telegram unterstützen.

Desinformationskampagnen und Propaganda finden nicht nur in klassischen Sozialen Medien statt, sondern auch in Messenger-Diensten wie WhatsApp, Telegram oder Signal. Letztere sind in dieser Hinsicht bislang jedoch wenig wissenschaftlich untersucht. Forschende aus Bochum und Lausanne haben eine neue Methode entwickelt, um Accounts aufzuspüren, die systematisch Propaganda in Telegram-Kanälen verbreiten. Sie funktioniert schneller, günstiger und effektiver, als menschliche Moderatorinnen und Moderatoren es können.

Das Verfahren präsentierte Prof. Dr. Rebekah Overdorf von der Ruhr-Universität Bochum, früher an der Universität Lausanne, gemeinsam mit Klim Kireev und Carmela Troncoso vom Bochumer Max-Planck-Institut für Sicherheit und Privatsphäre, früher an der École Polytechnique Fédérale de Lausanne, am 13. August 2025 auf dem USENIX Security Symposium in Seattle. Das Autor*innenteam wurde für seine Arbeit mit einem Distinguished Paper Award ausgezeichnet.

Rebekah Overdorf ist an der Ruhr-Universität Bochum Professorin für Security and Trustworthiness of Online Information. Sie ist außerdem Mitglied des Research Centers Trustworthy Data Science and Security.

Telegram ist in einigen Ländern, beispielsweise in Russland und der Ukraine, ein wichtiger Informationskanal. Die Moderation der Inhalte liegt auf der Plattform in den Händen der Personen, die eine Gruppe oder einen Kanal betreiben. Eine unabhängige Instanz, die Fakten checkt, gibt es nicht. Moderatorinnen und Moderatoren können die Regeln in ihren Gruppen und Kanälen selbst festlegen und entfernen unerwünschte Inhalte häufig manuell. Manche lassen sich auch von Software unterstützen, die normalerweise jedoch auf sehr einfachen Kriterien basiert, beispielsweise obszöne Wörter detektiert.

Russische und ukrainische Propaganda-Netzwerke gefunden

Die Forschenden analysierten für ihre Studie 13,7 Millionen Kommentare aus 13 Telegram-Kanälen mit politischem oder nachrichtlichem Fokus. 1,8 Prozent davon entpuppten sich als Propaganda. Ein Großteil wurde von einem pro-russischen Netzwerk verbreitet, das in manchen Kanälen bis zu 5 Prozent aller Nachrichten abgesetzt hatte. Auch ein kleineres pro-ukrainisches Propaganda-Netzwerk deckten die Forschenden auf.

Wie sich Propaganda-Accounts auf Telegram verhalten

Ihr Detektionsmechanismus basiert auf den Antworten, die die Propaganda-Accounts auf Accounts von normalen Userinnen und Usern geben. Wie die Forschenden zeigten, starten Propaganda-Accounts in Telegram keine Unterhaltungen, sondern reagieren auf Kommentare anderer User, die bestimmte Stichwörter enthalten, etwa Putin oder Selenskyj.

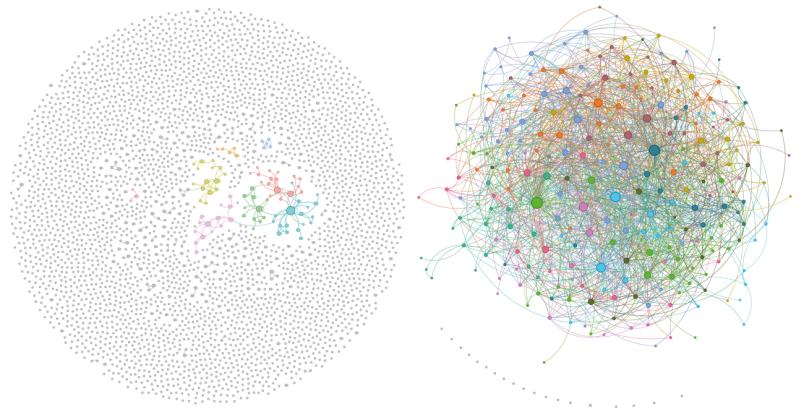

In diesem Diagramm repräsentiert jeder Punkt einen Telegram-Account. Eine Linie zeigt an, dass ein Account einen Kommentar eines anderen Accounts mit gleichem Wortlaut wiederholt hat. Die Darstellung zeigt, dass Propaganda-Accounts (rechts) sich deutlich anders verhalten als normale Accounts (links). Sie erzeugen Netzwerke, die immer wieder die gleichen Inhalte wiederholen.

Besonders charakteristisch für die Propaganda-Accounts ist, dass sie Nachrichten mit gleichem Wortlaut an unterschiedlichen Stellen posten, teils über verschiedene Kanäle hinweg. Während normale Accounts einzigartige Nachrichten verfassen, bilden die Propaganda-Accounts große Netzwerke, die immer wieder die gleichen Texte verbreiten. Diese Eigenschaft nutzten die Forschenden, um einen automatisierten Detektionsmechanismus zu programmieren. Er konnte Propaganda anhand eines einzelnen Kommentars mit einer Trefferrate von 97,6 Prozent erkennen, und damit um 11,6 Prozent besser als ein Mensch.

Menschliche Moderation ist unterschiedlich erfolgreich

In der Studie analysierte die Gruppe zudem, wie effizient Moderatorinnen und Moderatoren gegen Propaganda vorgehen. Das Ergebnis fiel für die untersuchten Kanäle sehr unterschiedlich aus. Während manche Nachrichtenkanäle nahezu 95 Prozent der Propaganda fanden und löschten, lag die Rate in anderen Kanälen bei knapp 20 Prozent. Nach Aussage der Kanalbetreiber erfordert das Entfernen von Propaganda einen hohen manuellen Aufwand. Durch den neu entwickelten Detektionsmechanismus könnte dieser deutlich sinken.

Das Forschungsteam weist zudem darauf hin, dass Content-Moderatorinnen und -Moderatoren nicht rund um die Uhr im Einsatz sein können und dass es negative psychische Effekte haben kann, wenn Menschen der Propaganda ständig ausgesetzt sind. „Wir hoffen daher, dass unser Algorithmus künftig bei der Moderation auf Telegram unterstützen kann“, so die Autorinnen und Autoren der Studie.