Statistik

Mit Extremen rechnen

Das Klima ist in Bewegung. Weil es sich im Lauf der Jahre ständig verändert, ist schwer zu berechnen, was früher der Normalzustand war – und wie die Gegenwart davon abweicht. Hier helfen besondere statistische Kniffe.

Der Winter 2023/24 war ausgesprochen regenreich. In manchen Regionen Deutschlands kam die Sonne gefühlt wochenlang nicht zum Vorschein. Landstriche, die eigentlich Wiesen und Felder sind, verwandelten sich in Seen. Was vielen Probleme bereitete, hatte auch etwas Positives: Die Grundwasserpegel erholten sich, was eine gute Basis für den kommenden Sommer legte. Denn wer weiß, ob dieser wieder neue Rekordtemperaturen bringt?

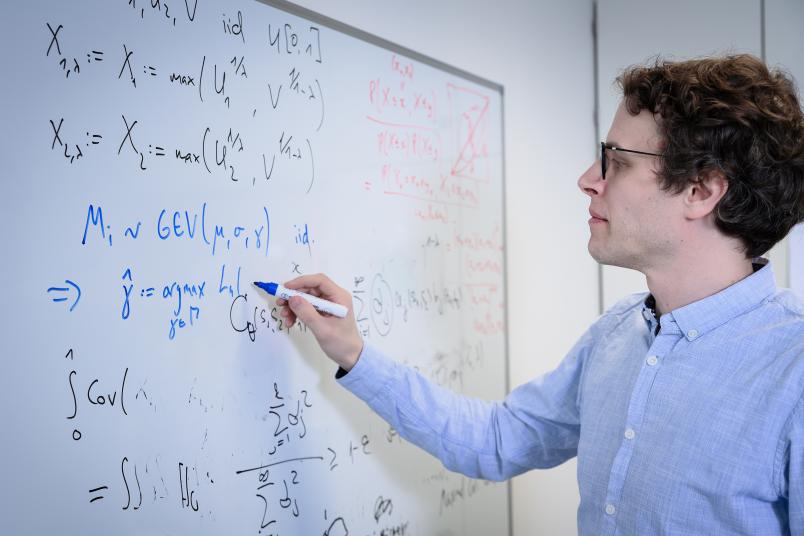

Diese Frage kann Prof. Dr. Axel Bücher nicht beantworten. Aber er kann berechnen, wie viel wahrscheinlicher bestimmte Extremwetter heute im Vergleich zu vor 100 Jahren sind. Bücher ist Mathematiker an der Ruhr-Universität Bochum und Mitglied im Projekt „ClimXtreme“, in das er während seiner Tätigkeit an der Heinrich-Heine-Universität Düsseldorf einstieg und das er nun in Bochum fortführt. Der interdisziplinäre Forschungsverbund hat zum Ziel, das Auftreten von Extremwettern zu verstehen, damit sich die Gesellschaft besser darauf vorbereiten kann. Und das hat viel mit Mathematik zu tun, genauer gesagt mit Statistik.

Axel Bücher ist Experte für Extremwertstatistik. Er optimiert Methoden, mit denen sich die Wahrscheinlichkeit von extremen Ereignissen zu verschiedenen Zeitpunkten vergleichen lässt. Beispielsweise von maximalen Temperaturen, Windgeschwindigkeiten oder Niederschlagsmengen. Seine Arbeit basiert auf der sogenannten generalisierten Extremwertverteilung. „Man muss sie sich ähnlich wie die Gauß-Verteilung vorstellen“, erklärt Bücher. „So wie die Summe vieler kleiner Zufälle die Gauß-Glockenkurve ergibt, folgen auch Extremwerte einer bestimmten Verteilung.“

Unsicherheiten minimieren

Wenn es um Klimadaten geht, ergibt sich aber ein Problem. „Satelliten- und Radardaten gibt es erst seit 40 bis 50 Jahren, Beobachtungsstationen seit etwa 100 Jahren“, sagt Axel Bücher. „In dieser Zeit war das Klima immer in Bewegung.“ Weil es sich ständig verändert hat, haben die Forschenden keine konstanten Daten über einen langen Zeitraum vorliegen, mit denen sie die heutigen Daten vergleichen könnten. Oder anders ausgedrückt: Es ist nicht so leicht zu bestimmen, welche Wetterereignisse früher normal waren.

Letztendlich bedeutet es, dass wir entweder heute ein um zehn Prozent effizienteres Verfahren nutzen können oder zehn Jahre länger Daten sammeln müssen.

Axel Bücher

Durch diese Umstände kommt Unsicherheit in die statistischen Berechnungen. Genau hier setzt Axel Büchers Forschung an. Er optimiert die bestehenden Verfahren so, dass die Unsicherheit kleiner wird. Eine im Projekt ClimXtreme entwickelte Methode beispielsweise verbessert die statistische Aussagekraft um 10 bis 15 Prozent. „Das klingt vielleicht nicht viel“, gibt Axel Bücher zu. „Aber letztendlich bedeutet es, dass wir entweder heute ein um zehn Prozent effizienteres Verfahren nutzen können oder zehn Jahre länger Daten sammeln müssen, um ein Ergebnis von ähnlicher Qualität zu bekommen.“

Bevor sein Verfahren auf Klimadaten angewendet wurde, hat Büchers Team – damals noch in Düsseldorf – es nach den Gepflogenheiten der Statistik-Forschung auf Herz und Nieren getestet. „Wir beweisen zum einen mathematisch, dass unsere Verfahren funktionieren, aber überprüfen sie auch in Simulationsstudien“, erklärt er. In solchen Untersuchungen lassen die Forschenden ihre Algorithmen eine Aufgabe lösen, deren Ergebnis bekannt ist. „So können wir schauen, ob wir mit unseren Verfahren richtig liegen“, verdeutlicht der Forscher.

Wie wahrscheinlich Starkregen an Ahr und Erft ist

Nachdem Büchers neuer Algorithmus die Tests bestanden hat, wollen die ClimXtreme-Kooperationspartner ihn künftig auf Extremwetterereignisse anwenden. „Damit ließe sich beispielsweise die Wahrscheinlichkeit von Niederschlägen in der Ahr-Erft-Region berechnen, in der es 2021 das verheerende Hochwasser gegeben hatte“, gibt Bücher ein Beispiel.

Eine Analyse zur Ahr-Erft-Region ist im Projekt ClimXtreme bereits mit anderen mathematischen Verfahren entstanden. Die Berechnungen – basierend auf Daten des Deutschen Wetterdienstes – ergaben, dass Extremniederschläge in der Region heute 1,2- bis 9-mal wahrscheinlicher sind als früher. Wenn das Klima so bleiben würde wie heute, müsste sich die Region etwa alle 400 Jahre auf solch extreme Niederschläge einstellen, wie sie 2021 zum Hochwasser führten. Diese Zahl gibt allerdings nur den geschätzten Mittelwert wieder. Die Unsicherheit wird durch das 95-Prozent-Konfidenzintervall ausgedrückt. Sein unteres und oberes Ende markiert den Bereich, in dem der wahre Wert mit 95-prozentiger Wahrscheinlichkeit liegt. Im Fall der Ahr-Erft-Studie betrug es 170 bis 2.500 Jahre. Mit Büchers Methode könnte sich das Konfidenzintervall künftig verkleinern lassen.

Die Datenbasis verbessern

Um die Datenbasis für solche Berechnungen zu verbessern, werden oft Daten von Beobachtungsstationen aus umliegenden Regionen einbezogen, die sich in den extremen Bereichen statistisch ähnlich verhalten. „Üblicherweise werden diese Regionen durch Meteorologie-Expertinnen und -Experten ausgesucht“, weiß Axel Bücher. Im Projekt ClimXtreme untersuchte er mit Partnern aus Düsseldorf, Oslo und vom Deutschen Wetterdienst, ob die so ausgewählten Regionen tatsächlich statistisch gesehen ähnlich zur Ahr-Erft-Region waren. 16 Regionen bezog das Team in die Analyse ein. „Beim Großteil kamen wir zum selben Ergebnis wie die Expertinnen und Experten. Wir hätten nur eine Region mehr in die Analyse aufgenommen, die die Expert*innen wegen fehlender Gleichheit aussortiert hatten“, beschreibt Bücher.

Wissenschaftsmagazin Rubin kostenlos abonnieren

Höchsttemperaturen im Ruhrgebiet

Die Verfahren des Bochumer Mathematikers funktionieren aber nicht nur für Niederschläge. Sie lassen sich prinzipiell auf alle möglichen Parameter übertragen. So berechnete er gemeinsam mit Leandra Zanger an der Heinrich-Heine-Universität Düsseldorf, wie sich die Maximaltemperaturen in verschiedenen deutschen Regionen in den vergangenen Jahrzehnten entwickelten, beispielsweise in der Ruhrgebietsstadt Essen.

Um die Klimaerwärmung in Zahlen zu fassen, wird häufig die globale Durchschnittstemperatur bemüht. In ihre Berechnung gehen die Temperaturen von 365 Tagen pro Jahr ein. Bücher und Zanger wählten einen anderen Ansatz: Sie suchten für jedes Jahr die maximale Tageshöchsttemperatur aus den Daten und verglichen die heutigen Werte mit denen vor rund 70 Jahren. So konnten sie zeigen, wie sich die Extreme wandeln.

Vier Grad mehr

„Während die globale Durchschnittstemperatur in dem beobachteten Zeitraum um 1,2 Grad Celsius gestiegen ist, sind die Maximaltemperaturen bereits rund 4 Grad Celsius geklettert“, sagt Bücher.

Künftig will sein Team im Rahmen von ClimXtreme daran arbeiten, die statistischen Verfahren als Software nutzbar zu machen, sodass auch Anwenderinnen und Anwender ohne mathematische Expertise sie für Berechnungen heranziehen können. Schließlich werden sie in Zukunft sicher noch häufiger gebraucht, wenn der nächste Hitzesommer vor der Tür steht oder sich wieder Felder in Seen verwandelt haben.