Medienwissenschaft

Die Welt, wie ein Roboter sie sieht

Um zu verstehen, wie die Welt in einen Roboter kommt, machten sich Forschende der Medienwissenschaft daran, einen Roboter von Grund auf zu konstruieren.

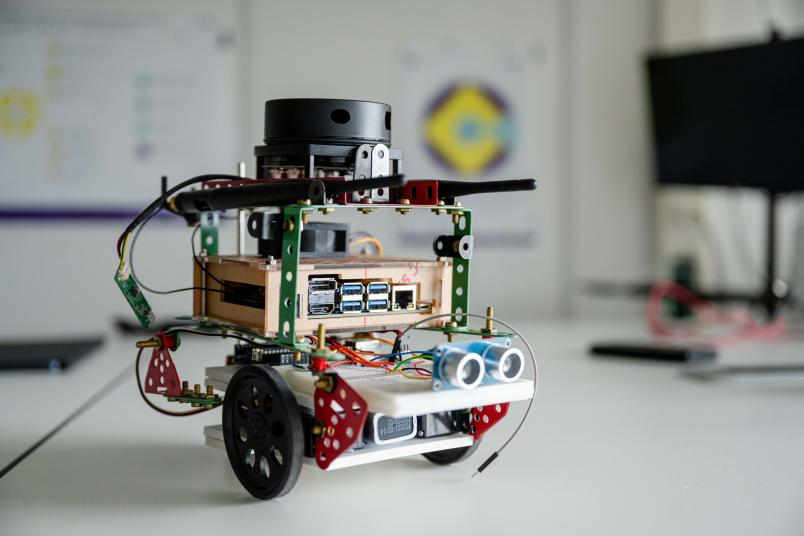

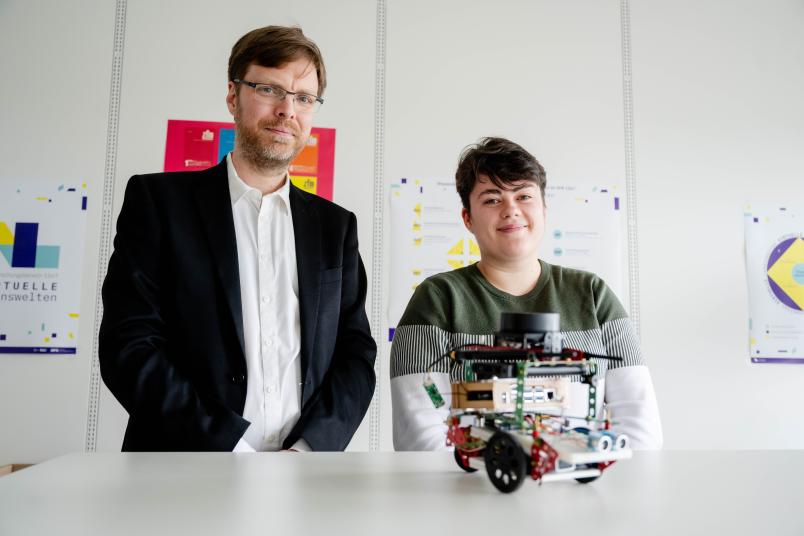

Er mutet ein wenig wie ein Kinderspielzeug an: Mit seinen drei Rädern, farbigen Kabeln und nach Augen aussehenden seitlichen Bauteilen steht jedoch ein selbstfahrender Roboter auf dem Tisch im Virtual Humanities Lab des Sonderforschungsbereichs Virtuelle Lebenswelten. Er ist versehen mit einem Sensor, der die Umgebung mittels Laser abtastet. Auf diese Weise gelangen Daten über die Welt ins System und erlauben es ihm, sich darin zu bewegen. Und genau dieser Prozess steht im Mittelpunkt des Forschungsprojekts.

„Uns beschäftigt die Frage, wie die Welt in den Roboter gelangt, oder anders: wie sich autonome Fahrzeuge in Umgebungen orientieren“, erklärt Doktorand Alex Schmiedel. Diese Frage ist weniger technisch gemeint als vielmehr darauf bezogen, welche Entscheidungen getroffen werden müssen, damit aus den Daten, die das System generiert, ein Modell der Welt entsteht, mit dem das Fahrzeug interagieren kann. „Wir wollen die Übersetzungsschritte aufschlüsseln und damit die Rolle des Menschen klären, der diese Entscheidungen treffen muss“, erklärt Schmiedel. Beim industriellen Bau autonomer Autos spielen diese Entscheidungen im Einzelnen keine Rolle mehr – vieles ist bereits standardisiert, viele Bauteile und Prozesse liegen vorgefertigt vor und werden nur noch zusammengesetzt. „Aber all diesen Standards wohnen Vorannahmen inne, die jemand eines Tages gemacht hat, darin sind Entscheidungen festgelegt, die einmal getroffen wurden“, erläutert Schmiedel. Und diese möchte er in seiner Dissertation am Institut für Medienwissenschaft herausarbeiten.

Fehler offenbaren zugrunde liegende Entscheidungen

Augenfällig werden solche Entscheidungsprozesse vor allem da, wo Fehler passieren. „Es ist mit einem autonom fahrenden Auto zum Beispiel in den USA zu einem tödlichen Unfall gekommen, weil das Fahrzeug eine Frau mit einem Fahrrad nicht korrekt erkannt hatte“, berichtet Prof. Dr. Florian Sprenger, der die Arbeit von Alex Schmiedel betreut. „Das System hätte eine Person allein vermutlich sicher erkennen können, ebenso ein Fahrrad. Aber in der Kombination war das Ganze nicht zu interpretieren.“ Alex Schmiedel hat sich eingehend mit Normen zum Thema beschäftigt und unter anderem Hinweise zu Sicherheitstests der autonomen Orientierungstechnik ausgewertet. „Darin ist zum Beispiel festgehalten, dass Dummies in solchen Tests keine flatternde Kleidung tragen sollten, da solche Kleidungsstücke schlecht für die Systeme zu erkennen sind“, berichtet er. „Solche Entscheidungen haben einige Tragweite, wenn wir zum Beispiel daran denken, dass Clubgänger*innen in genau solcher Kleidung vielleicht nachts und bei für die Sensoren schlechten Sichtverhältnissen nach Hause gehen“, gibt er zu bedenken.

Um den Ketten dieser Entscheidungen auf die Spur zu kommen, zieht das Forschungsprojekt auch historische Dokumente aus der Entwicklungszeit autonom fahrender Systeme heran. Das Hauptaugenmerk liegt aber auf der eigenen Konstruktion eines solchen Systems – bewusst ohne das Vorwissen, das Ingenieur*innen mitbringen. „Das autonome Fahrzeug von Null an selbst zu konstruieren hat ungefähr ein Semester gedauert, drei Wochen davon sehr intensiv“, sagt Alex Schmiedel. „Das ging nur im Team – und es hat richtig Spaß gemacht.“ Das Scheitern gehörte für die Forschenden zum Prozess dazu.

Rotierender Laser-Sensor tastet die Umgebung ab

Sie entschieden sich als Sensor für ein LIDAR-System, kurz für Light Detection and Ranging. Es tastet die Umgebung mit nicht sichtbaren Infrarot-Laserstrahlen ab und funktioniert auch im Dunkeln. „Es ist ein recht neues System und steht nicht so sehr im Fokus wie andere Technologien“, erklärt Alex Schmiedel. Ähnlich wie bei der Radartechnik basiert LIDAR darauf, dass unterschiedliche Materialien das Licht auf verschiedene Weise reflektieren. LIDAR-Sensoren können Daten aus einer 360-Grad-Umgebung gewinnen, weil sich der Sensor in schneller Geschwindigkeit um sich selbst dreht.

Die vom Laser empfangenen Lichtimpulse werden in numerische Werte übersetzt. Das selbst konstruierte Fahrzeug übermittelt die so generierten Daten an einen Rechner. Und dann beginnen die Entscheidungen: Sollen bestimmte Daten als Linie interpretiert werden? Oder entsprechen sie einem Punkt? Wie kommt das System dahinter, ob es sich bei einem reflektierenden Objekt um ein bewegliches Objekt handelt, zum Beispiel einen Menschen, oder nicht? „Wir sprechen von einer Pipeline der Übersetzungsschritte bis hin zu einem Modell der Welt“, sagt Alex Schmiedel. Diese Entscheidungen, einmal festlegt, müssen selbstfahrende Autos in der realen Welt in Echtzeit durchlaufen, um sicher unterwegs zu sein. Damit das funktioniert, werden Künstliche Intelligenzen eingesetzt, die das leisten, was das Projekt als Mikroentscheidungen erforscht: zahlreiche in extrem kurzen Zeitspannen geleistete Entscheidungen.

„Roboter haben kein Bewusstsein“, bringt es Alex Schmiedel auf den Punkt. „Wir wollen wissen, wie sie durch solche Mikroentscheidungen ein Modell der Welt hervorbringen, mit dem sie interagieren können.“