Benchmark

Harte Nüsse für die KI

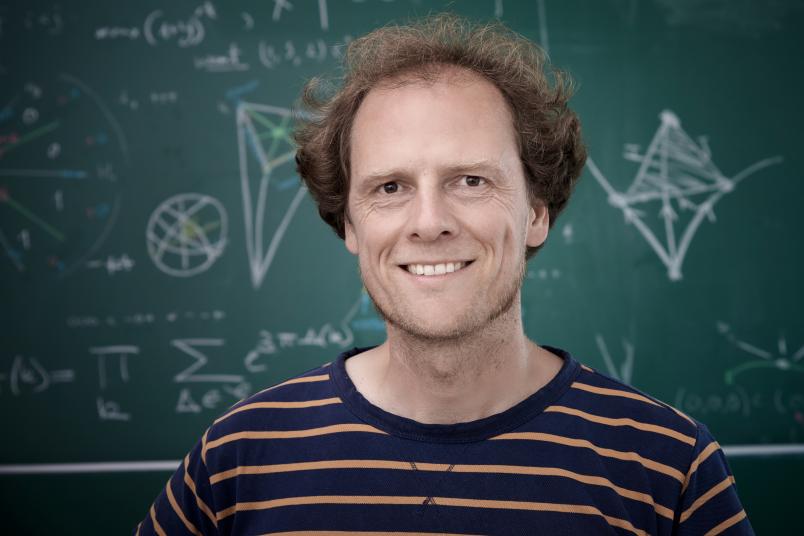

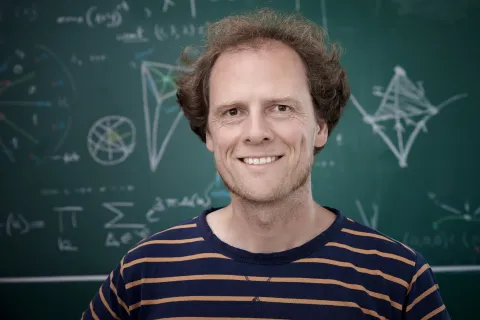

Christian Stump und Alexander Ivanov haben drei Fragen zu „Humanity’s Last Exam“ beigesteuert.

Generative Künstliche Intelligenzen scheinen auf jede Frage eine Antwort zu haben. Aber was können sie wirklich? Um sie auf die Probe zu stellen, wurde der Benchmark-Datensatz „Humanity’s Last Exam“ zusammengestellt, der 550 Fragen enthält, die die sogenannten Large Language Models ins Schwitzen bringen sollen. Drei dieser Fragen, die aus über 70.000 Einreichungen ausgewählt wurden, haben die Mathematiker der Ruhr-Universität Bochum Prof. Dr. Christian Stump und Prof. Dr. Alexander Ivanov eingereicht.

Neun Prozent brauchbare Antworten

Rund 1.000 Expertinnen und Experten aus 50 Ländern trugen Fragen für den Testdatensatz bei. Sämtliche Fragen, die aufgenommen wurden, waren bislang unveröffentlicht. „Wäre das nicht so, könnte sich die KI die Antworten einfach heraussuchen“, erläutert Christian Stump. Die RUB-Fragen stammen wie 40 Prozent aller aufgenommenen Fragen aus der Mathematik und könnten auch Ausgangspunkte für eine Doktorarbeit sein.

Je abstrakter, desto besser

„Dass so viele mathematische Fragen im Datensatz sind, liegt daran, dass der Blick auf die Argumentationsketten der KI desto besser gelingt, je abstrakter eine Frage ist“, sagt Christian Stump. Die getesteten KIs mehrerer Anbieter konnten nur neun Prozent aller Fragen des Datensatzes sinnvoll beantworten. „Auf die übrigen Fragen spucken die Modelle einfach Quatsch aus“, berichtet Christian Stump. „Ich habe mich beteiligt, weil es um Grundsatzfragen für meine eigene Forschung geht: Welche Fragen muss man sich überhaupt noch stellen? Wo kann man einfach die KI fragen? Das ist super interessant.“