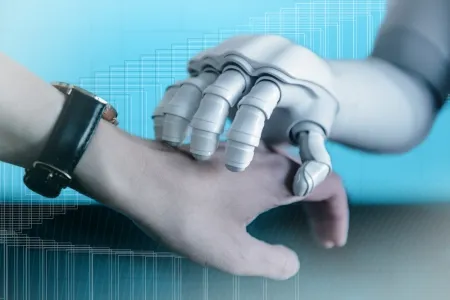

Das linke Motiv ist ein echtes Bild von einem Hund und einer Katze. In das rechte Motiv bauten die Forschenden ein Wasserzeichen ein, dass das Bild für ein Machine-Learning-Modell generiert aussehen lässt. Der Einbau des Wasserzeichens hinterließ kaum Spuren im Bild; die manipulierte Version zeigt leicht verschobene Kanten und minimale Unschärfe im Vergleich zum Original-Bild.

Informatik

Semantische Wasserzeichen zur KI-Bilderkennung leicht manipulierbar

Wasserzeichen sollen helfen zu entscheiden, ob ein Bild echt ist oder nicht. Aber die Technik lässt sich leicht austricksen.

Mit Künstlicher Intelligenz (KI) generierte Bilder sind für das menschliche Auge von echten Bildern oft kaum zu unterscheiden. Eine Lösung für dieses Problem könnten Wasserzeichen sein – sichtbare oder unsichtbare Kennzeichnungen in Bilddateien, die nachweisen, ob ein Bild von einer KI erzeugt wurde. Als besonders robust und schwer zu entfernen galten bislang sogenannte semantische Wasserzeichen, die direkt während der Bilderstellung tief in den Entstehungsprozess eingebettet werden. Forschende aus der Cybersicherheit der Ruhr-Universität Bochum zeigen jedoch, dass diese Annahme trügt. Auf der „Computer Vision and Pattern Recognition (CVPR)“-Konferenz am 15. Juni 2025 in Nashville, USA, zeigten sie in einem Vortrag grundlegende Sicherheitslücken semantischer Wasserzeichen auf.

„Wir konnten zeigen, dass Angreifer mit vergleichsweise einfachen Mitteln semantische Wasserzeichen fälschen oder komplett entfernen können“, erklärt Andreas Müller aus der Fakultät für Informatik der Ruhr-Universität Bochum. Zusammen mit den Bochumer Forschenden Dr. Denis Lukovnikov, Jonas Thietke, Prof. Dr. Asja Fischer und Dr. Erwin Quiring hat er zwei neue Angriffsmöglichkeiten entwickelt.

Zwei neue Angriffe entwickelt

Die erste Methode, die sogenannte Imprinting-Attacke, arbeitet auf der Ebene der latenten Repräsentationen – also der tieferliegenden digitalen Signatur eines Bildes, auf der KI-Bildgeneratoren arbeiten. Dabei wird die verborgene Darstellung eines echten Bildes – sozusagen seine digitale Struktur – gezielt so angepasst, dass sie der eines wasserzeichen-behafteten Bildes ähnelt. So lässt sich das Wasserzeichen auf jedes beliebige echte Bild übertragen, obwohl das Referenz-Bild ursprünglich rein künstlich erzeugt war. Ein Angreifer kann einem KI-Anbieter gegenüber somit jedes beliebige Bild als wasserzeichenbehaftet, also generiert, aussehen lassen und somit gezielt echte Bilder als Fake aussehen lassen.

„Die zweite Methode, der Reprompting-Angriff, nutzt die Fähigkeit, ein wasserzeichen-behaftetes Bild in den latenten Raum zurückzuführen und anschließend mit einem neuen Prompt neu zu generieren. So entstehen beliebige neue generierte Bilder, die das gleiche Wasserzeichen tragen“, erklärt Co-Autor Dr. Erwin Quiring, ebenfalls Mitglied der Fakultät für Informatik.

Angriffe funktionieren unabhängig von KI-Architektur

Beide Angriffstechniken benötigen nur ein einziges Referenzbild mit dem Ziel-Wasserzeichen und funktionieren modellübergreifend – das heißt, sie sind unabhängig von der konkreten KI-Architektur, funktionieren also sowohl für ältere Diffusion-Modelle mit UNet als auch für neuere Diffusion Transformer. Das macht die Angriffe besonders gefährlich und zeigt die enorme Herausforderung bei der Absicherung dieser Wasserzeichentechnologie.

Für die Zukunft der Wasserzeichentechnologie sind diese Erkenntnisse laut den Forschenden besorgniserregend, weil es derzeit keine effektive Gegenmaßnahme gegen diese Angriffe gebe. „Das wirft die Frage auf, wie wir KI-generierte Inhalte künftig sicher kennzeichnen und authentifizieren können,“ so Andreas Müller. Die Bochumer Forschenden fordern daher, semantische Wasserzeichen grundlegend zu überdenken, um sie widerstandsfähiger und vertrauenswürdiger zu machen.

Förderung

Originalveröffentlichung