Blindenradar Folgen Sie dem Ton

Die Welt wie eine Fledermaus wahrnehmen und sich ohne Seheindrücke sicher orientieren: Für Sehbehinderte wäre das eine große Hilfe. Ingenieure arbeiten daran.

Ein zarter Ton wie eine angezupfte Saite ist mein einziger Halt im Raum. Mit geschlossenen Augen, die Ohren unter einem Kopfhörer, manövriere ich mein virtuelles Ich per Knopfdruck durch einen verwinkelten digitalen Flur. In kurzen Abständen erklingt der Ton vor mir. Per Knopfdruck bewege ich mich einen Schritt darauf zu. Jetzt erklingt der Ton ein wenig weiter links. Ich wende mich ihm ein kleines Stück zu, sodass er wieder in der Mitte vor mir ist. Noch ein Schritt. Er bleibt in der Mitte. Ein weiterer Schritt.

So lotst mich der Ton zuverlässig durch den Gang. Ich ecke nicht an, laufe nicht vor eine Wand. Allmählich gewinne ich an Zutrauen und gehe zügiger. Zu zügig anscheinend – ein Warnton erklingt. Stehenbleiben, neu orientieren. Ton in der Mitte vorn, weiter.

Intuitiv zu nutzen

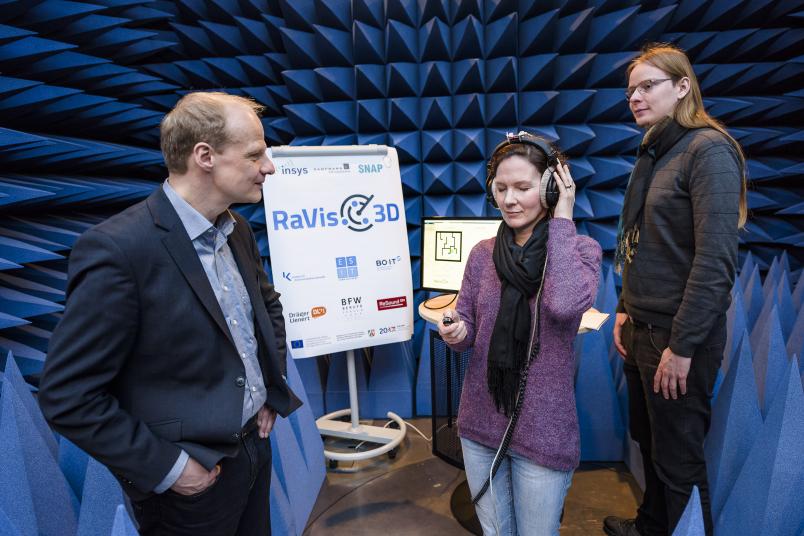

Ich bin überrascht, wie intuitiv das System funktioniert, denn die Einweisung von Privatdozent Dr. Gerald Enzner vom Institut für Kommunikationsakustik war bewusst knapp. Zusammen mit Christoph Urbanietz hat er in einem schalltoten Raum im Keller des Gebäudes ID heute den sogenannten Sonifikationssimulator aufgebaut. „Wir machen das gerne hier, weil wir hier abgeschirmt sind von der Umgebungsakustik, sodass man sich in dieser vorläufigen Entwicklungsphase erst einmal nur auf den leitenden Ton konzentrieren kann“, erklärt er.

Diesen Ton, die angezupfte Saite, hat Christoph Urbanietz ausgesucht – er sei einfach eine intuitiv gute Wahl gewesen, erzählt er augenzwinkernd. In zweierlei Hinsicht ein Glücksgriff, denn zum einen ist er kurz und besonders gut zu orten. Zum anderen ist er angenehm und einladend. Er nervt nicht. Daher wendet man sich ihm gerne zu und folgt ihm. Der Warnton dagegen ist schräg und abweisend.

Hinter dem Tonsignal, das eines Tages Blinde durch unbekanntes Terrain lotsen soll, steckt eine Menge Technik, die noch ausgearbeitet, verfeinert, verkleinert werden muss. Das planen die Forscher im Projekt Ravis-3D, das etwas länger als ein halbes Jahr läuft. Der Sonifikationssimulator setzt einen virtuellen Grundriss in Tonsignale um. Rückmeldung über die Bewegungen des Nutzers bekommt er über einen Bewegungssensor auf dem Kopfhörer und durch ein Zeigeinstrument, über das man pro gedachtem Schritt einen Knopfdruck macht. Später wird sich der Träger des Systems selbst im echten Raum bewegen, und seine Bewegungen werden über Sensoren erfasst werden.

System soll kleiner werden

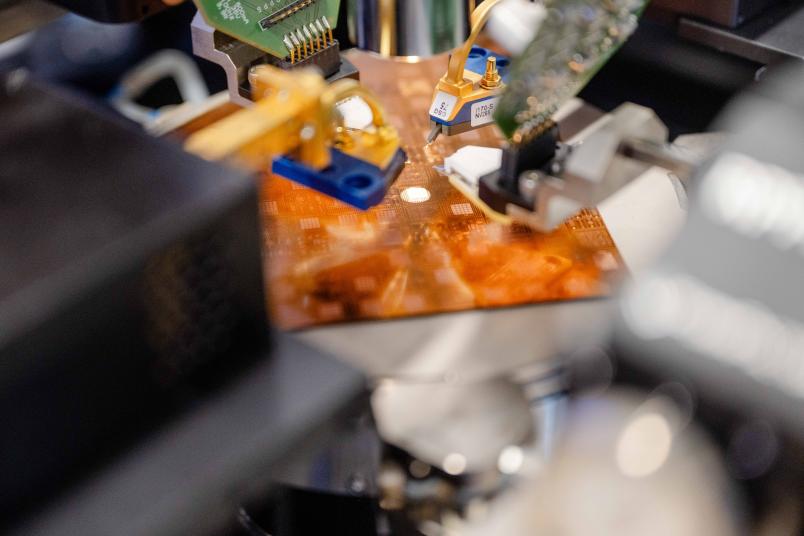

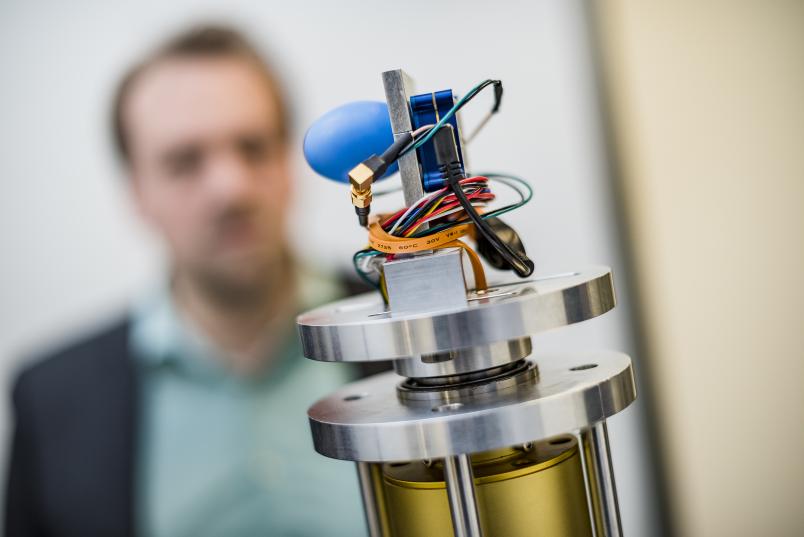

Der virtuelle Grundriss, auf dem die Tonerzeugung basiert, entsteht dann durch die Abtastung der Umgebung mittels Radar. Das Prinzip habe ich ein paar Etagen höher in einem Flur des Gebäudes ID schon besichtigen können. Hier hat das Team von Prof. Dr. Nils Pohl vom Lehrstuhl Integrierte Systeme ein mannshohes Stativ aufgebaut, auf dem sich eine komplizierte Vorrichtung ständig um sich selber dreht und dabei leise Zwitschergeräusche macht. Wie mir Nils Pohl erklärt, sind die meisten Komponenten der Apparatur nur dafür zuständig, den oberen Teil zu drehen. Die damit befassten Elektromotoren erzeugen das Geräusch. „Das eigentlich Interessante ist der Radarsensor ganz oben. Er befindet sich auf einem Mikrochip und ist nur zwei mal zwei Millimeter groß“, sagt Pohl.

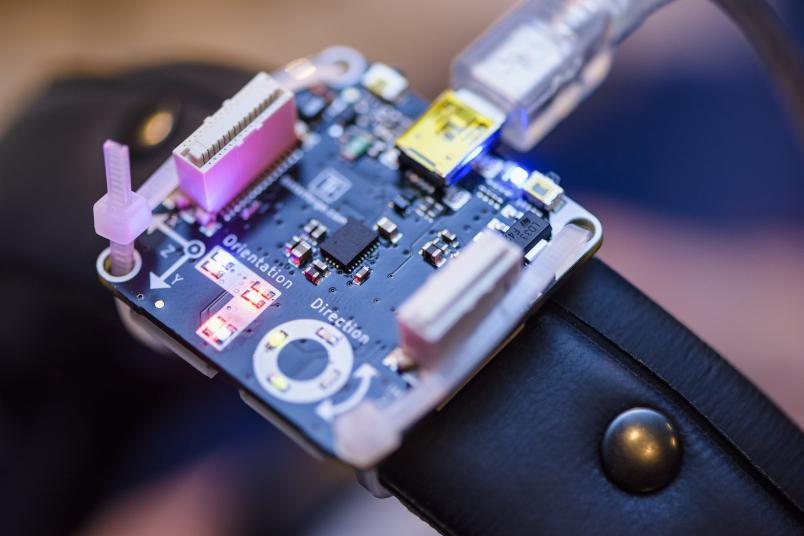

Das kleine blaue Ei ist eine Radarantenne, dahinter in einem blauen Kästchen der Sensor. Ihn haben die Bochumer Ingenieure entwickelt, und mit ihm haben sie noch viel vor. Kleiner soll er werden, und er soll es ermöglichen, das für die Orientierung im Raum notwendige Blickfeld ohne Eigendrehung der Antenne zu erfassen. Ob man dafür einen Blickwinkel von 30 oder 60 Grad oder noch einen ganz anderen braucht, muss noch näher untersucht werden. Sicher ist, dass das gesamte System schließlich in einem Stirnband, einer Brille oder im Knauf eines Taststocks Platz finden soll.

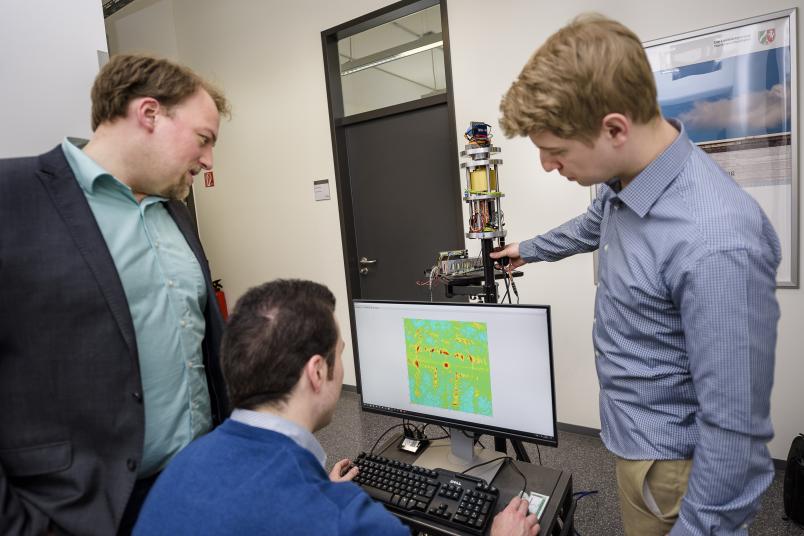

Auf dem Monitor eines angeschlossenen Computers ist zu sehen, wie die durch Radarmessung erzeugte Repräsentation unserer Umgebung hier aussieht. Auf überwiegend grünlichem Grund sind Muster in Rot und Gelb zu erkennen. Sie stellen Gegenstände dar, die die vom Radar ausgesandten elektromagnetischen Wellen reflektieren, sodass sie der Sensor wieder empfängt. „Der Fleck hier bin ich“, zeigt Nils Pohl, und macht einen Schritt zur Seite. Mit der nächsten Drehung des Radarsystems, mit der sich das Bild erneuert, bewegt sich auch sein Punkt auf dem Bildschirm ein Stück. Die Wände sind als unregelmäßige Reihen von unförmigen Flecken erkennbar. Verdickungen sind zum Beispiel Türrahmen. „Metall reflektiert so gut, dass es stärker dargestellt wird“, so Nils Pohl.

Ursprünglich andere Anwendung geplant

Eigentlich haben es die Forscher mit ihrem Radarsystem auf ganz andere Anwendungen abgesehen. Sie haben zum Beispiel Füllstandsmesssysteme für Industrietanks entwickelt und Komponenten für selbstfahrende Autos. Dabei kam dem Lehrstuhlmitarbeiter Timo Jaeschke die Idee, die Technik als Orientierungshilfe für Sehbehinderte einzusetzen.

Schon jetzt, noch ganz zu Anfang der dreijährigen Projektlaufzeit, fasziniert die Idee – nicht nur mich, sondern auch viele Medienvertreter, die schon zu Besuch waren. „Dabei werden wir erst in zwei Jahren so weit sein, dass wir wirklich etwas zeigen können“, sagt Nils Pohl.

Bis dahin steht dem Team noch viel Arbeit bevor. Zahlreiche Fragen, nicht nur technischer Art, sind noch offen. Die Simulation zum Beispiel funktioniert wie ein Navigationssystem. Mein Ton kann mich nur lotsen, weil er weiß, wohin ich will. Was aber, wenn ein sehbehinderter Mensch irgendwo aus dem Bus steigt und nicht weiß, wo es lang geht? „Daran arbeiten wir“, sagt Gerald Enzner.