Neuroinformatik

Warum es künstliche Intelligenz eigentlich noch nicht gibt

Die Prozesse, die der künstlichen Intelligenz heute zugrunde liegen, sind eigentlich dumm. Bochumer Forscher arbeiten daran, sie schlauer zu machen.

Umbruch, Revolution, Megatrend, vielleicht auch Gefahr: Das Thema künstliche Intelligenz durchdringt alle Branchen, beschäftigt sämtliche Medien. Forscherinnen und Forscher des Instituts für Neuroinformatik an der RUB befassen sich seit 25 Jahren damit. Ihr Credo: Damit Maschinen wirklich intelligent agieren können, müssen neue Ansätze maschinelles Lernen erst einmal effizienter und flexibler machen.

Mann oder Frau?

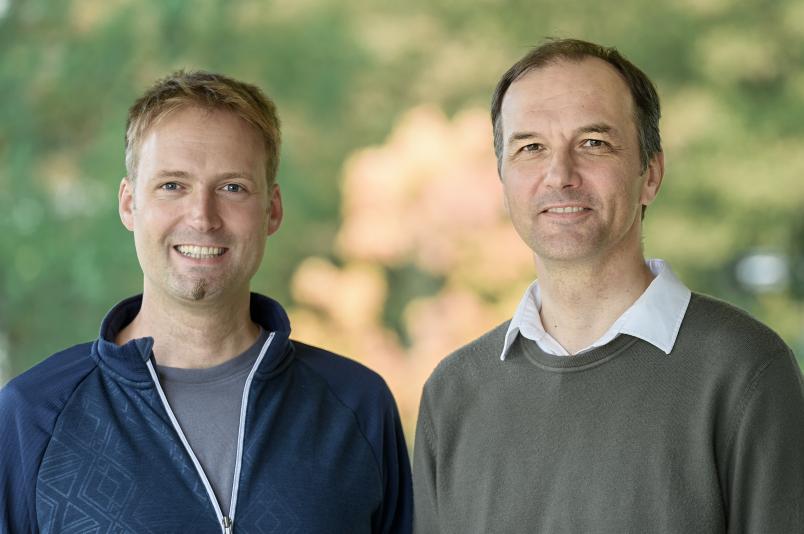

„Zwei Arten des maschinellen Lernens sind heute erfolgreich: zum einen tiefe neuronale Netze, auch als Deep Learning bekannt. Zum anderen das Verstärkungslernen“, erklärt Prof. Dr. Laurenz Wiskott, Inhaber des Lehrstuhls Theorie Neuronaler Systeme.

Neuronale Netze sind dazu geeignet, komplexe Entscheidungen zu treffen. Häufig werden sie bei der Bilderkennung eingesetzt. „Sie können zum Beispiel an Fotos von Personen erkennen, ob es sich um einen Mann oder um eine Frau handelt“, beschreibt Wiskott.

Die Architektur solcher Netze ist inspiriert durch Netzwerke von Nervenzellen, oder Neuronen, in unserem Gehirn. Neurone nehmen über mehrere Eingangskanäle Signale auf und entscheiden dann, ob sie das Signal in Form eines elektrischen Impulses an die nächsten Neuronen weitergeben oder nicht.

Auch das neuronale Netz bekommt mehrere Eingangssignale, zum Beispiel Bildpunkte. In einer ersten Stufe errechnen viele künstliche Neuronen aus mehreren Eingangssignalen jeweils ein Ausgangssignal, indem die Eingänge einfach mit unterschiedlichen, aber konstanten Gewichten multipliziert und dann aufaddiert werden. Jede dieser Rechenoperationen ergibt einen Wert, der – um bei dem Beispiel Mann/Frau zu bleiben – ein wenig zur Entscheidung für weiblich oder männlich beiträgt. „Allerdings wird das Ergebnis noch ein wenig verändert, indem negative Resultate auf Null gesetzt werden. Auch das ist von der Nervenzelle abgeguckt und ganz wesentlich für die Leistungsfähigkeit von neuronalen Netzen“, erläutert Laurenz Wiskott.

Stufenweise zur Entscheidung

Dasselbe passiert in einer nächsten Stufe wieder, solange bis das Netzwerk in der letzten Stufe zu einer Entscheidung kommt. Je mehr Stufen der Prozess umfasst, desto erfolgreicher ist er – neuronale Netze mit über 100 Stufen sind nicht selten. Häufig lösen neuronale Netze Unterscheidungsaufgaben besser als Menschen.

Der Lerneffekt solcher Netze liegt in der Wahl der richtigen Gewichtungsfaktoren, die anfangs zufällig gewählt sind. „Für das Training eines solchen Netzwerks gibt man nicht nur Eingangssignale vor, sondern auch, was am Ende für eine Entscheidung herauskommen soll“, erklärt Laurenz Wiskott. So kann das Netzwerk die Gewichtungsfaktoren nach und nach anpassen, um schließlich mit der größtmöglichen Wahrscheinlichkeit die korrekte Entscheidung zu treffen.

Das Verstärkungslernen ist hingegen inspiriert von der Psychologie. Hier wird jede Entscheidung des Algorithmus – die Experten sprechen vom Agenten – entweder belohnt oder bestraft. „Stellen wir uns ein Raster vor, in dessen Mitte der Agent sich befindet“, erläutert Laurenz Wiskott. „Sein Ziel ist es, das Kästchen ganz oben links auf dem kürzesten Weg zu erreichen – aber das weiß er nicht.“ Das einzige, was der Agent will, ist, möglichst viele Belohnungen zu bekommen, sonst ist er ahnungslos. Anfangs wird er daher völlig zufallsgesteuert über das Spielfeld gehen, und jeder Schritt, der nicht das Ziel erreicht, wird bestraft. Nur der Schritt ins Ziel bedeutet eine Belohnung.

Das Problem mit diesen Prozessen maschinellen Lernens ist, dass sie im Grunde strohdoof sind.

Laurenz Wiskott

Um lernen zu können, versieht der Agent jedes Feld mit einem Wert, der anzeigt, wie viele Schritte es von hier aus noch zum Ziel sind. Anfangs sind diese Werte rein zufällig. Je mehr Erfahrung der Agent auf seinem Spielfeld sammelt, desto besser kann er diese Werte der Realität anpassen. Nach zahlreichen Durchgängen kann er so den schnellsten Weg zum Ziel und somit zur Belohnung finden.

„Das Problem mit diesen Prozessen maschinellen Lernens ist, dass sie im Grunde strohdoof sind“, sagt Laurenz Wiskott. „Die zugrunde liegenden Techniken stammen aus den 1980er-Jahren. Der Grund für ihren heutigen Erfolg liegt nur darin, dass wir heute größere Rechenkapazitäten haben und mehr Daten.“ Das macht es möglich, die eigentlich ineffizienten Lernprozesse in ihren unzähligen Durchgängen in kürzester Zeit durchlaufen zu lassen und neuronale Netze mit Massen von Bildern und Bildbeschreibungen zu füttern, um sie zu trainieren.

„Wir wollen aber wissen: Wie lässt sich zum einen das viele unsinnige Training vermeiden? Und vor allem: Wie können wir maschinelles Lernen flexibler machen?“, bringt es Wiskott auf den Punkt. Denn künstliche Intelligenz mag in genau der einen Aufgabe, für die sie trainiert wurde, dem Menschen überlegen sein – verallgemeinern oder auf verwandte Aufgaben übertragen kann sie ihr Wissen nicht.

Die Forscherinnen und Forscher am Institut für Neuroinformatik setzen daher auf neue Strategien, die Maschinen helfen, Strukturen selbstständig zu entdecken. „Dafür nutzen wir unter anderem das Prinzip des unüberwachten Lernens“, sagt Laurenz Wiskott. Während tiefe neuronale Netze und Verstärkungslernen darauf basieren, dass man das gewünschte Ergebnis mit präsentiert beziehungsweise jeden Schritt belohnt oder bestraft, lassen die Forscher lernende Algorithmen mit ihrem Input weitgehend alleine.

Die Lösung des Rätsels nicht mitliefern

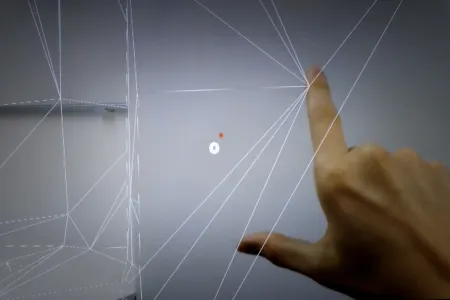

„Eine Aufgabe könnte etwa sein, Cluster zu bilden“, erläutert Wiskott. Dafür gibt man dem Computer die Anweisung, ähnliche Daten zu Gruppen zusammenzufassen. Stellt man sich Punkte in einem dreidimensionalen Raum vor, würde das bedeuten, Punkte, deren Koordinaten nahe beieinanderliegen, zu gruppieren. Eine große Entfernung der Koordinaten voneinander bedeutet die Zuordnung zu verschiedenen Gruppen.

„Wiederum bezogen auf das Beispiel der Bilder von Personen könnte man nach der Gruppierung das Ergebnis anschauen und würde wahrscheinlich feststellen, dass der Computer eine Gruppe mit Männerbildern und eine Gruppe mit Frauenbildern zusammengestellt hat“, so Laurenz Wiskott. „Der große Vorteil ist, dass man dafür anfangs nur Fotos braucht, keine Bildbeschreibung, die sozusagen die Lösung des Rätsels zu Trainingszwecken schon enthält.“

Langsamkeit nutzen

Außerdem verspricht diese Methode mehr Flexibilität, denn die Clusterbildung funktioniert auf diese Art nicht nur für Bilder von Personen, sondern auch für solche von Autos, Pflanzen, Häusern oder anderen Dingen.

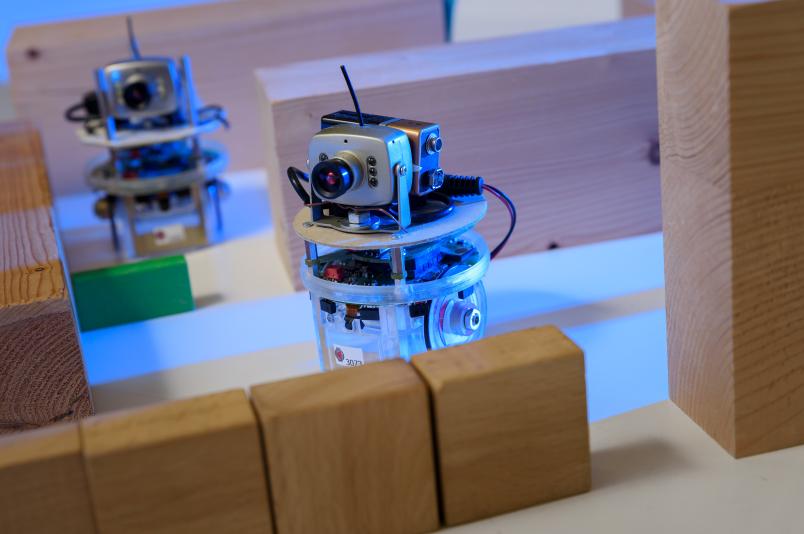

Dabei geschieht das Training mit einem maschinellen Lernverfahren, der Spieler macht nur grobe Vorgaben.

Ein anderer Ansatz, den Wiskott verfolgt, ist das Prinzip der Langsamkeit. Hier besteht das Eingangssignal nicht aus Fotos, sondern aus bewegten Bildern: Wenn man aus einem Video diejenigen Merkmale extrahiert, die sich nur langsam verändern, lassen sich darin Strukturen entdecken, die helfen, eine abstrakte Repräsentation der Umgebung aufzubauen. „Es geht auch hierbei darum, die Eingangsdaten vorzustrukturieren“, verdeutlicht Laurenz Wiskott. Schließlich kombinieren die Forscher solche Ansätze modular mit den Methoden des überwachten Lernens, um so zu flexibleren Anwendungen zu gelangen, die trotzdem sehr treffsicher sind.

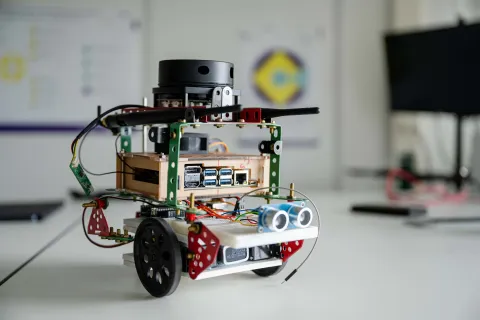

„Natürlich führt ein Mehr an Flexibilität zu einem Verlust an Performance“, so der Forscher. „Aber auf lange Sicht, wenn wir Roboter wollen, die mit neuen Situationen umgehen können, ist Flexibilität unverzichtbar.“