Wissenschaftsdidaktik

„KI-Tools werden den akademischen Betrieb nicht zum Einsturz bringen“

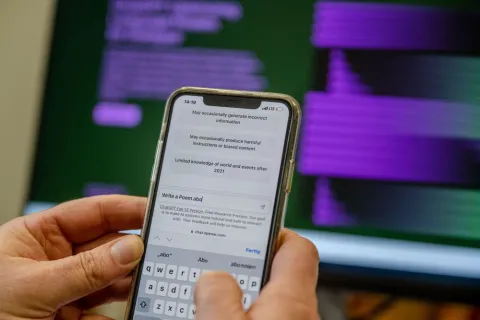

Das Tool ChatGPT produziert Texte, die klingen wie von Menschen geschrieben. Es hat einen regelrechten Hype ausgelöst. Kein Grund zur Panik, meint Expertin Nadine Lordick.

Der Chatroboter ChatGPT ist in aller Munde. Er rechnet, schreibt Gedichte, beantwortet Wissensfragen. Verfasst er bald auch Haus- und Doktorarbeiten – und stellt die universitäre Ausbildung auf den Kopf? Expertinnen und Experten vom Zentrum für Wissenschaftsdidaktik beschäftigen sich schon seit Jahren mit der Frage, was Tools, die auf Künstlicher Intelligenz (KI) basieren, für die Lehre bedeuten – unter anderem im Projekt KI:edu.nrw, für das Nadine Lordick arbeitet. Im Interview beantwortet sie viele Fragen rund um ChatGPT.

Frau Lordick, müssen wir uns darauf einstellen, dass ChatGPT die universitäre Lehre über Nacht auf den Kopf stellt?

Nein, auch wenn in manchen Diskussionen derzeit dieser Eindruck entstehen kann. Ich beschäftige mich vor allem mit den Auswirkungen auf das wissenschaftliche Schreiben aus schreibdidaktischer Perspektive. Schreiben im Studium und in der Wissenschaft hat vielfältige Gründe und wird nicht plötzlich an Bedeutung verlieren, nur weil ChatGPT Textabschnitte verfassen kann, und es wird nicht alle Prüfungsformen über den Haufen schmeißen.

Trotzdem muss man damit rechnen, dass Teile von Hausarbeiten künftig von einer KI geschrieben werden.

Ja, aber man darf nicht alle Studierenden unter Generalverdacht stellen. Bloß weil es geht, werden nicht alle die Technik nutzen, um sich bei Prüfungen durchzumogeln. Es gab auch früher schon Möglichkeiten, zu täuschen und Hausarbeiten nicht komplett selbst zu schreiben. Nun ist eine Möglichkeit hinzugekommen, die in der Tat sehr leicht zugänglich ist. Aber deswegen werden nicht alle Studierenden auf einmal den Wunsch haben, nicht mehr selbst zu schreiben. Viele sind motiviert, Arbeiten zu Themen zu verfassen, die ihnen gefallen. Schreiben ist aber komplex und anspruchsvoll, daher gibt es in unserem Schreibzentrum viele Unterstützungsangebote für Studierende.

Ich verstehe die Sorge.

Ich verstehe trotzdem die Sorge, dass es künftig mehr Hausarbeiten geben wird, die nicht selbst erstellt wurden. Aber KI-Tools werden unseren akademischen Betrieb nicht zum Einsturz bringen.

Kann man denn herausfinden, ob ein Text von ChatGPT geschrieben wurde oder von einem Menschen?

Bei KI-generierten Texten funktioniert das nicht gut. Die Algorithmen sind darauf ausgelegt, einzigartige Texte zu generieren, die möglichst denen ähneln, die von Menschen verfasst sind. Einige bekannte Anwendungen vor ChatGPT wurden unter anderem für den kommerziellen Bereich entwickelt, beispielsweise für das Verfassen von Produktbeschreibungen und werblichen Blog-Posts, wo man nicht unter Plagiatsverdacht geraten möchte. Die ausgegebenen Texte sind also immer unterschiedlich.

Lehrende sollten ihren Studierenden daher die Vor- und Nachteile solcher Techniken erklären. Es ist wie mit Wikipedia: Den Studierenden ist klar, dass das keine zitierbare Quelle ist und nicht die Basis für eine Hausarbeit sein kann. Trotzdem kann man nicht verhindern, dass sie sich auf Wikipedia informieren. Es bringt nichts zu sagen: „Wikipedia ist doof“. Man muss vielmehr die Limitationen erklären und andererseits auch aufzeigen, wo es hilfreich sein kann. So sollte man bei den KI-Schreibtools auch vorgehen.

Wenn man versucht, eine Hausarbeitsfrage von dem Tool beantworten zu lassen, wird man schnell desillusioniert.

Aktuell sind die Antworten von ChatGPT oft noch sehr oberflächlich. Wenn man versucht, eine Hausarbeitsfrage von dem Tool beantworten zu lassen, wird man schnell desillusioniert. So weit kommt man dann doch nicht.

Werden sich die Prüfungskulturen in Zukunft verändern müssen, um den neuen Tools Rechnung zu tragen?

Darüber denken wir viel nach und wollen auch Lehrende sensibilisieren, darüber nachzudenken. Ich glaube nicht, dass es von heute auf morgen radikale Veränderungen geben wird. Es gab auch vorher schon technologischen Fortschritt: von der Schreibmaschine zum Computer, irgendwann mit Rechtschreibprüfung. Bestimmte Dinge wurden einfacher, dafür andere komplexer. Jetzt werden ähnliche Veränderungen passieren.

Rechtschreibung spielt in der Bewertung heute beispielsweise weniger eine Rolle als früher. Gerade wird diskutiert, ob man künftig den Stil eines Textes vielleicht weniger hoch gewichten wird, weil man sich Texte von einem Programm glätten lassen kann. Ich denke, da werden sich mit der Zeit neue Konventionen ausbilden.

Sind mehr mündliche Prüfungen eine Lösung?

Größere Reflexion einzufordern ist eine Möglichkeit, zum Beispiel durch die Verteidigung einer Arbeit in einer mündlichen Prüfung, in der man erklären muss, wie man zu seinen Thesen gekommen ist. Lernbegleitendes Prüfen kann auch eine Lösung sein. Man bekommt am Ende nicht nur eine Hausarbeit, sondern zwischendurch immer wieder Ergebnisse zugeschickt und spricht öfter mit den Studierenden darüber. Durch den engeren Kontakt sieht man eher, wenn auf einmal Ergebnisse kommen, die zu vorherigen nicht passen.

Das klappt aber nicht, wenn man Hunderte von Studierenden in einem Studiengang hat.

Das stimmt. Ein Stück weit muss man auch darauf vertrauen, dass Studierende Werte von akademischer Integrität anerkennen.

Wichtig ist, dass man sich überlegt, was die Studierenden lernen sollen und wie man es hinterher prüfen kann.

Gute Lehre setzt immer Reflexion voraus. Wichtig ist, dass man sich überlegt, was die Studierenden lernen sollen und wie man es hinterher prüfen kann. Diese Frage bleibt gleich und muss nun unter neuen Rahmenbedingungen gestellt werden – und zwar in den einzelnen Fächern. Es ist etwas anderes, ob ich eine Hausarbeit in der Philosophie schreibe oder ein Laborprotokoll in der Naturwissenschaft. Es werden unterschiedliche Dinge gefordert und man muss disziplinspezifisch überlegen, ob eine Künstliche Intelligenz sinnvoll zum Einsatz kommen kann oder eher hinderlich ist.

In der Fremdsprachenlehre ist das Thema übrigens gar nicht so neu. Durch „DeepL“ kann man sich schon länger von einer KI helfen lassen, fremdsprachliche Texte zu verfassen.

KI und Fremdsprachen

Wie könnte man KI-basierte Schreibtools sinnvoll in den universitären Alltag integrieren?

Gewisse Aufgaben wie das Formulieren eines gut lesbaren Textes kann man in Zukunft vielleicht an eine KI auslagern, wenn man möchte. Viele Forschende klagen beispielsweise darüber, dass das Verfassen von Abstracts, also Zusammenfassungen für wissenschaftliche Publikationen, eine lästige Arbeit sei. Das könnte künftig eine KI übernehmen. Aber man muss sich Gedanken machen, ob man eine solche Technik schon im Studium nutzen sollte. Es kann sehr sinnvoll sein, das Schreiben von Abstracts zu lernen. Es ist also nicht unbedingt die Frage, ob wir die Technik einsetzen wollen, sondern eher ab wann.

Im Moment wird sehr viel über ChatGPT diskutiert. Ist die Technik eigentlich neu?

Nein, gar nicht. Mich hat es überrascht, dass ChatGPT zu so einem Hype geführt hat. Das Sprachmodell, auf dem es beruht – GPT-3 – gibt es schon länger, und es gab früher schon Anwendungen, die es für die Textproduktion genutzt haben. Auch andere Tools wie Jasper.AI haben schon ähnlich gut funktioniert wie ChatGPT.

Warum dann der Hype?

Weil ChatGPT einerseits leichter zu nutzen ist als seine Vorgänger, beispielsweise der „Playground“ von OpenAI, der ebenfalls auf dem Sprachmodell GPT-3 basiert. Für diese Anwendung musste man die richtigen Befehle kennen, um einen guten Text herauszubekommen. ChatGPT hat nun ein vereinfachtes Interface. Es ist ein Chat, ich kann mich sozusagen damit unterhalten. Andererseits kosteten die Tools, die zuvor schon einfacher zu nutzen waren, meist relativ viel und waren deswegen weniger zugänglich.

ChatGPT kann viele Sachen gut, viele auch nicht.

Ist abzusehen, wohin die Weiterentwicklung solcher Tools führen wird?

Was man absehen kann, ist eine Spezialisierung. Es werden verschiedene Anwendungen für verschiedene Kontexte entwickelt werden. ChatGPT ist für einen sehr breiten Kontext entstanden. Es kann viele Sachen gut, viele auch nicht. Wenn man eine KI mit einer spezifischen Textsorte, beispielsweise wissenschaftlichen Texten, trainiert, wird sie auch gut darin sein, solche Texte zu verfassen – besser als ChatGPT. Generell werden auch die Sprachmodelle noch besser werden und die damit produzierten Texte noch ähnlicher zu denen von Menschen klingen.

Wie werden Sie das Thema weiter an der RUB begleiten?

Wir haben kürzlich eine große Infoveranstaltung für Lehrende abgehalten, um grundlegende Informationen zu der Technik und den daraus folgenden rechtlichen und didaktischen Fragen zu vermitteln. Außerdem führen wir derzeit Fokusgruppengespräche, weil wir herausfinden wollen, was die Technik für die unterschiedlichen Disziplinen bedeutet. Natürlich haben wir auch darüber hinaus am Zentrum für Wissenschaftsdidaktik immer ein offenes Ohr für Lehrende, die sich dazu austauschen wollen.